Il existe un test célèbre, proposé dès 1950 par le brillant mathématicien Alan Turing, qui vise à évaluer si une machine est capable de manifester un comportement intelligent au point de ne plus pouvoir être distingué de celui d’un être humain. Il s’appelle le « test de Turing » et est considéré comme une étape importante dans l’étude de l’intelligence artificielle. Eh bien, il semble que cet objectif lointain ait enfin été atteint, du moins selon les résultats d’une expérience récente dans laquelle le chatbot GPT-4 a réussi à être confondu avec un humain dans 54 % des conversations.

Un record qui bat non seulement son prédécesseur GPT-3.5, mais aussi un véritable participant. Signe que l’IA devient de plus en plus « humaine » ? Ou simplement la démonstration de son habileté à tromper nos perceptions ? C’est certainement le signe que la frontière entre intelligence naturelle et intelligence artificielle deviendra de plus en plus mince et floue. Avec toutes les merveilles et les embûches que cela comporte.

GPT-4 trompe plus d’un humain sur deux au test de Turing

Le test en question, dont les résultats ont été publiés sur la plateforme de pré-print arXiv (je les relie ici), impliquait 500 personnes qui ont été invitées à converser pendant 5 minutes avec quatre interlocuteurs différents : un humain et trois systèmes d’intelligence artificielle.

Parmi ceux-ci se trouvaient l'”ancien” programme ELIZA, datant des années 1960 et basé sur des réponses prédéfinies, le modèle GPT-3.5 et le plus avancé GPT-4, le même qui est à la base du chatbot dont on parle tant ChatGPT.

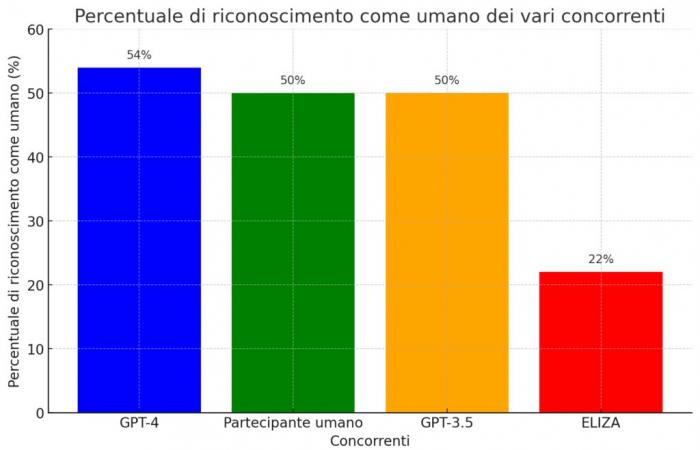

Eh bien, à la fin des conversations, il a été demandé aux participants d’indiquer quels interlocuteurs ils considéraient comme humains et lesquels étaient artificiels. Et c’est là que les surprises sont apparues : GPT-4 a réussi à être confondu avec un humain dans 54% de cas, voire un pourcentage supérieur à celui du participant humain (stationnaire à 50 %). Les deux autres « concurrents » numériques étaient nettement séparés : GPT-3.5 s’est également arrêté à 50 %, tandis que la rudimentaire ELIZA a été jugée humaine dans seulement 22 % des conversations.

Un résultat sensationnel qui semble marquer un tournant sur la voie de la création d’intelligences artificielles de plus en plus proches des humaines. Avec toutes les questions éthiques et sociales que cela implique.

Non seulement l’intelligence, mais aussi l’empathie et les « défauts » humains.

Mais qu’est-ce qui rend GPT-4 si « humain » pour qu’il parvienne à tromper la majorité des interlocuteurs ? Selon les experts, il ne s’agit pas seulement d’« intelligence » au sens strict, entendue comme la capacité à traiter l’information et à apporter des réponses pertinentes. Il y a bien plus.

Les modèles linguistiques sont infiniment flexibles, capables de synthétiser des réponses sur un large éventail de sujets, de parler des langues ou des sociolectes particuliers, et de se représenter avec une personnalité et des valeurs inspirées par le caractère. C’est un énorme pas en avant par rapport à quelque chose de préprogrammé par un humain, aussi habilement et soigneusement soit-il.

Nell Watsonchercheur en IA à l’Institute of Electrical and Electronics Engineers (IEEE).

En d’autres termes, GPT-4 ne se limite pas à afficher des connaissances et des capacités de raisonnement, mais sait aussi se « mettre à la place » de l’interlocuteur, en modulant le langage et l’attitude en fonction du contexte. Ce n’est pas tout : selon Watson, ces systèmes d’IA avancés présentent également des traits typiquement humains tels que la tendance à fabuler, à être soumis à des biais cognitifs, à être manipulés. Autant de caractéristiques qui les rendent encore plus semblables à nous, défauts compris. Ceci explique le « triomphe » du test de Turing.

De nouveaux défis pour l’interaction homme-machine

Si les machines parviennent de mieux en mieux à paraître humaines, comment comprendrons-nous avec qui nous interagissons réellement ? C’est l’une des questions soulevées par l’étude, qui craint le risque d’une « paranoïa » croissante dans les interactions en ligne, notamment sur des sujets sensibles ou confidentiels.

Un scénario pas si loin de la réalité, si l’on pense au nombre de fois où nous interagissons quotidiennement avec des assistants numériques, des chatbots et d’autres systèmes d’IA sans même nous en rendre compte. Avec le risque d’être influencé ou manipulé sans le savoir.

Les capacités ne représentent qu’une petite partie de la valeur de l’IA : leur capacité à comprendre les valeurs, les préférences et les limites des autres est tout aussi essentielle. Ce sont ces qualités qui permettront à l’IA de servir de concierge fidèle et fiable pour nos vies.

Bref, si d’une part l’évolution de systèmes comme GPT-4 ouvre des scénarios passionnants de collaboration entre intelligence humaine et intelligence artificielle, d’autre part elle nous oblige à repenser les frontières et les modalités de ces interactions. Pour éviter de se perdre dans un monde où réalité et fiction se confondent, et de soupçonner qu’il y a une machine derrière chaque conversation.

La fiabilité du test de Turing en question

Ensuite, il y a une autre question soulevée par l’étude, ce que la bonne âme d’Alan me défend : celle de la validité réelle du test de Turing comme étalon de l’intelligence artificielle. Selon les auteurs eux-mêmes, en effet, le test serait trop simpliste dans son approche, accordant plus de poids aux facteurs « stylistiques et socio-émotionnels » qu’aux capacités intellectuelles réelles.

En d’autres termes, des systèmes comme GPT-4 seraient très efficaces pour « paraître » intelligents, imitant parfaitement la façon dont les humains s’expriment et interagissent, sans l’être réellement. Une capacité qui risque de nous faire surestimer leur véritable « QI ».

Ce n’est pas un hasard si l’étude parle de « conséquences sociales et économiques généralisées » liées à l’avènement d’une IA de plus en plus « humaine ». De la perte d’emplois à l’altération des dynamiques sociales, en passant par les risques de manipulation et de désinformation. Autant de questions qui nécessitent une réflexion profonde sur la place que l’on souhaite donner à ces technologies dans nos vies.

Bref, le « succès » de GPT-4 au test de Turing est certes un acquis historique dans le chemin de l’intelligence artificielle, mais il ouvre aussi une série de questions épineuses sur la relation entre l’homme et la machine. Quelle que soit la réponse à ces questions, l’impression est que l’on va bientôt se demander si cette réponse a été donnée par une personne réelle ou non. Et c’est peut-être là la vraie nouvelle.